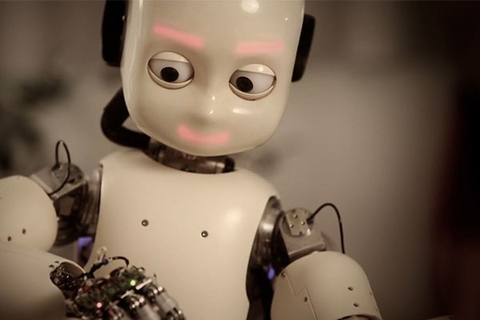

【财新网】(专栏作家 蔡凯龙)人工智能发展目前最大的障碍在于缺乏人类的信任。人类不愿意相信机器,因为人工智能冰冷的理性思维无法理解人类感性思维,以及人类在伦理道德上的规范。我们难以相信机器人在面对伦理道德抉择的时候,能做出“人性”的判断。归根结底,我们人类和机器人不一样。而且人类天生具有优越感,毕竟聪明强大的AlphaGo也是人类创造出来的,所以无法把包括伦理道德在内的所有决定都交给机器人负责。这是对人类尊严的亵渎。然而人工智能势不可挡,人类该不该信任机器?解决办法很简单,技术提升,让机器人有情感,能够和人类一样感性判断,人类就可以信任它。这个方法乍看可行,但是目前技术上很难实现。即使技术上有可能,人类会因为恐惧而不敢使用。我们愿意面对一个强大的、理性的、行为可预测的机器人,还是一个强大的、感性的、行为不可预测甚至有主见的机器人?另一个解决办法,人类自身改变。人类不信任机器人根源在于人类的心理。人的适应能力很强,随着时间的推移、人工智能的发展和普及,人类逐步调整自己的心态,逐渐信任机器人,与之共存。看看手机出现到现在短短20多年,人类对手机依赖的转变历史,我们不难推测,在不远的将来,人类和机器人关系也会如此。信任问题解决了,但是原来的问题依旧存在:人类愿意抛弃尊严和优越感,把包括伦理道德的所有决定交给机器人吗?把充满未知性和不确定性的人类社会变成一个纯粹理性和计算出来的社会?这是一个大问题!

推荐进入财新数据库,可随时查阅宏观经济、股票债券、公司人物,财经数据尽在掌握。

京公网安备 11010502034662号

京公网安备 11010502034662号